概率图

概率图模型(Probabilistic Graphical Model, PGM),简称图模型(Graphical Model,GM),是指一种用图结构来描述多元随机变量之间条件独立性的概率模型,从而给研究高维空间的概率模型带来了很大的便捷性。

为什么讲条件独立性呢?

对于一个 维随机向量,其联合概率为高维空间中的分布,一般难以直接建模。假设有

为离散随机变量并且有 个取值,在不作任何假设的情况下,则需要 个参数才能表示其概率分布。参数是指数级的,我们在多元高斯分布中也反复说明过 高维问题,贝叶斯分类器条件假设。

一种可以减少参数量的方法就是独立性假设。将 维随机变量的联合概率分解为 个条件概率的乘积。

其中 表示变量 的取值。如果某些变量之间存在条件独立,其参数量就可以大幅减少。

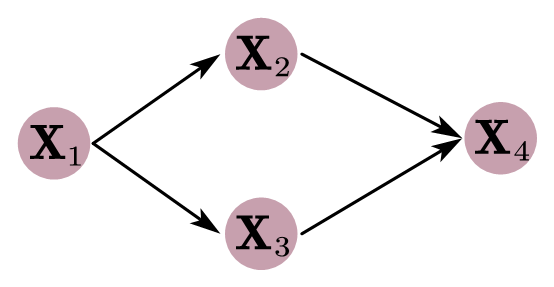

假设有四个二值随机变量,在不知道这几个变量依赖关系的情况下,用一个联合概率表示需要 个参数。但是假设已知 时, 和 独立,即有

同理: 当然,也可以写做:

另外,在已知 和 时, 也和 独立,即有

那么其联合概率 可以分解为:

这样就大大简化了联合概率分布的计算,而概率图可以直观的表示随机变量间条件独立性的关系。下面就是 个变量之间的条件独立性的图形化描述

假设观测对象是高维随机变量 ,对于这样的高维随机变量而言,其概率满足一下规则

概率的规则

- : 就是求边缘概率

- :

根据这两个基本法则,可以推出下面法则:

- :

概述

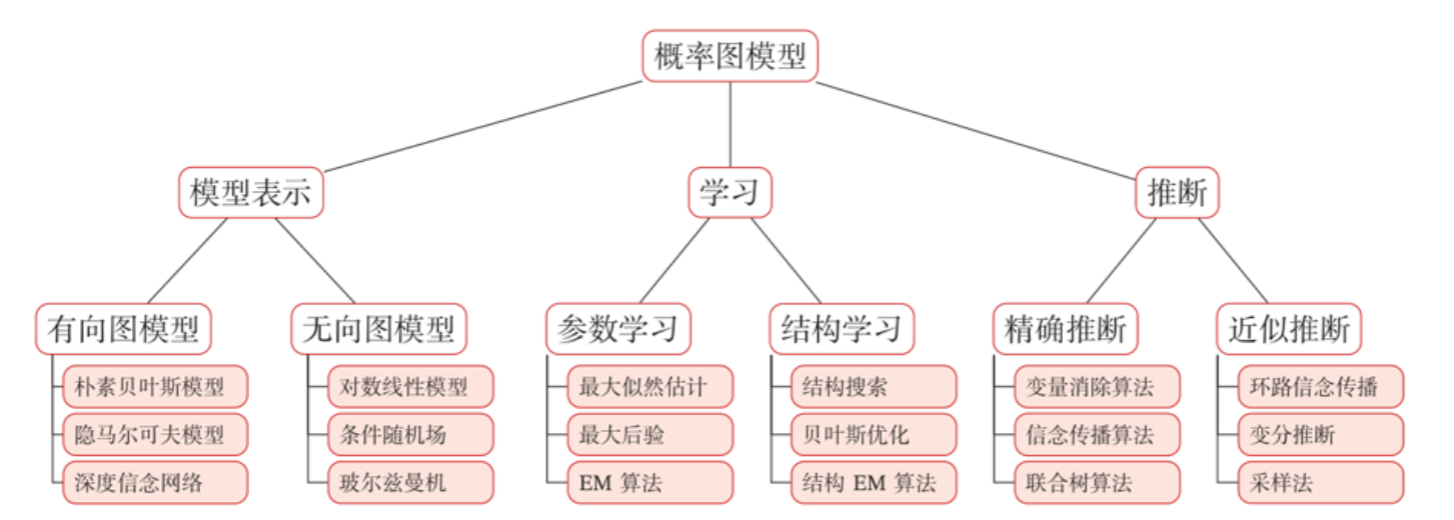

对于概率图模型我们有三个主要任务,表示、学习、推断

表示: 有向/无向

- 有向图模型使用有向非循环图(Directed Acyclic Graph,DAG)来描述变量之间的关系。如果两个节点之间有连边,表示对应的两个变量为因果关系,即不存在其他变量使得这两个节点对应的变量条件独立。

有向图又称贝叶斯网络,从模型的条件独立性依赖的个数上看,可以分为单一模型和混合模型,单一模型条件依赖的集合就是单个元素,��而混合模型条件依赖的集合则是多个元素。如果给模型加上时间概念,则可以有马尔科夫链和高斯过程等。从空间上,如果随机变量是连续的,则有如高斯贝叶斯网络这样的模型。混合模型加上时间序列,则有隐马尔科夫模型、卡尔曼滤波、粒子滤波等模型。

- 无向图模型使用无向图(Undirected Graph)来描述变量之间的关系。每条边代表两个变量之间有概率依赖关系,但是并不一定是因果关系。